特斯拉失控原因分析 駕駛員誤操作還是系統(tǒng)故障?

特斯拉汽車的失控事故頻頻引發(fā)公眾關(guān)注。究竟是駕駛員操作不當,還是軟件系統(tǒng)存在缺陷?本文將從軟件開發(fā)的角度探討這一問題。

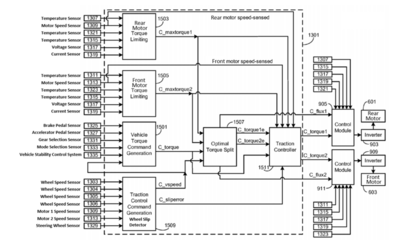

特斯拉的自動駕駛系統(tǒng)依賴于復(fù)雜的軟件算法和傳感器網(wǎng)絡(luò)。系統(tǒng)通過攝像頭、雷達和超聲波傳感器收集環(huán)境數(shù)據(jù),再通過深度學(xué)習(xí)模型進行實時決策。軟件在極端場景下可能出現(xiàn)誤判,例如在惡劣天氣或復(fù)雜路況中,系統(tǒng)可能無法準確識別障礙物,導(dǎo)致車輛失控。軟件更新過程中的漏洞也可能引入新的風(fēng)險,例如2021年某次OTA升級后部分用戶報告了制動系統(tǒng)異常。

另一方面,駕駛員誤操作也是事故的重要原因。特斯拉的Autopilot等功能要求駕駛員保持注意力,但部分用戶過度依賴系統(tǒng),在系統(tǒng)提示接管時未能及時反應(yīng)。數(shù)據(jù)顯示,多數(shù)事故發(fā)生在駕駛員分心或違反操作指南的情況下。例如,美國國家公路交通安全管理局(NHTSA)的調(diào)查指出,多起特斯拉事故與駕駛員濫用自動駕駛功能有關(guān)。

值得注意的是,軟件與人為因素的交互加劇了問題。例如,系統(tǒng)界面設(shè)計可能導(dǎo)致駕駛員誤解車輛狀態(tài),而預(yù)警機制的延遲或缺失則放大了操作失誤的后果。從軟件開發(fā)角度看,加強系統(tǒng)的冗余設(shè)計、完善測試流程(如模擬極端用例)以及提升人機交互的直觀性,是減少失控風(fēng)險的關(guān)鍵。

特斯拉失控事故往往是軟件系統(tǒng)局限性與駕駛員行為共同作用的結(jié)果。通過更嚴格的軟件開發(fā)標準和用戶教育,或許能在技術(shù)創(chuàng)新與安全之間找到平衡。

如若轉(zhuǎn)載,請注明出處:http://m.zyfk120.com/product/21.html

更新時間:2026-02-20 05:29:38